IN DEZE HANDLEIDING:

Deindexeer pagina’s voor meer traffic en betere SEO

Blog / Wil je meer verkeer? Deindexeer uw pagina’s. Dat is de reden.

De meeste mensen vragen zich af hoe ze Google zover kunnen krijgen dat ze hun pagina’s indexeren en niet de-indexeren. Uiteraard proberen de meeste mensen te voorkomen dat ze helemaal worden gedeïndexeerd.

Als u uw autoriteit op de resultatenpagina’s van zoekmachines probeert te vergroten, kan het verleidelijk zijn om zoveel mogelijk pagina’s op uw website te indexeren. En meestal werkt het. Maar dat helpt u niet altijd om het meeste verkeer te genereren.

Waarvoor? Het is waar dat het publiceren van een groot aantal pagina’s met gerichte trefwoorden u kan helpen een hogere ranking te behalen voor die specifieke trefwoorden.

Het kan echter nuttiger zijn voor uw ranking om bepaalde pagina’s op uw site buiten de index van een zoekmachine te houden. Hierdoor wordt verkeer naar relevante pagina’s geleid en wordt voorkomen dat onbelangrijke pagina’s worden weergegeven wanneer gebruikers Google gebruiken om naar inhoud op uw site te zoeken.

Waarom zou je een pagina wel of niet laten indexeren?

Wel indexeren wanneer:

• De pagina waardevolle informatie bevat die je wilt tonen in zoekresultaten.

• De pagina verkeer moet aantrekken via zoekmachines.

• De inhoud uniek, relevant en geoptimaliseerd is voor SEO.

Niet indexeren wanneer:

• De pagina dunne of dubbele inhoud bevat (bijvoorbeeld bedankpagina’s, interne zoekresultaten).

• Je geen zoekverkeer op die pagina wilt, zoals bij tijdelijke acties of testpagina’s.

• Je content privacygevoelig is of exclusief bedoeld voor bestaande klanten.

Crawlen en indexeren uitgelegd

In de wereld van SEO betekent het verkennen van een site het volgen van een pad. Crawl verwijst naar een sitecrawler (ook wel spider genoemd) die uw links volgt en elke centimeter van uw website doorzoekt. Crawlers kunnen HTML–code of hyperlinks valideren. Ook kunnen ze gegevens van bepaalde websites halen, dit heet webscraping.

Wanneer Google-bots naar uw website komen om deze te crawlen, volgen ze andere gelinkte pagina’s die zich ook op uw site bevinden. Bots gebruiken deze informatie vervolgens om zoekers te voorzien van actuele gegevens over uw pagina’s. Ze gebruiken het ook om ranking-algoritmen te creëren. Dit is een van de redenen waarom sitemaps zo belangrijk zijn. Sitemaps bevatten alle links op uw site, waardoor Google-bots uw pagina’s gemakkelijk diepgaand kunnen onderzoeken.

https://getcredo.com/britney-muller/

Webpagina’s niet indexeren met WordPress plugin

Ik gebruik regelmatig de Rank Math als SEO-plug-in. Hier mee is het het makkelijkst. Je kan ook andere SEO plugins gebruiken. Lees dan de handleidingen:

Seopressor SEO Plugin hoger in Google zoekresultaten

Eén van de beste seo plugins voor WordPress Seopressor is één van mijn favoriete SEO plugins. Niet voordelig, wel erg goed! Het is een van de beste seo-plugins voor WordPress. Meer dan 1.20.000+…

Yoast SEO WordPress plugin handleiding site optimaliseren

All in One SEO Pack plugin WP optimaliseren Google

Rankmath SEO WP plugin zoekmachine optimalisatie

https://neilpatel.com/blog/deindex-your-pages/

Indexeren beheren met RankMath

RankMath installeren en activeren

Als RankMath nog niet is geïnstalleerd:

• Ga naar Plugins > Nieuwe plugin.

• Zoek op “RankMath SEO”.

• Klik op Nu installeren en daarna Activeren.

Open de pagina of het bericht dat je wilt bewerken

• Ga in WordPress naar Pagina’s of Berichten en kies de juiste.

SEO-instellingen openen

• Klik bovenaan of aan de zijkant op het RankMath-logo of het tabblad SEO.

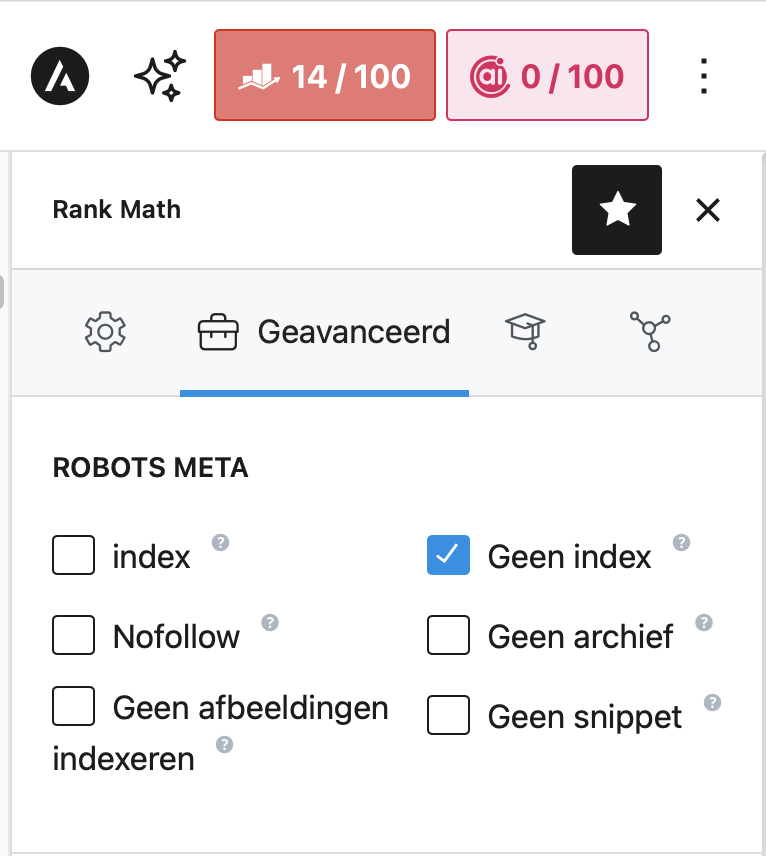

Index-instellingen Rankmath

Onder het tabblad Geavanceerd zie je opties zoals:

• Noindex: Schakel deze in om de pagina niet te laten indexeren.

• Nofollow: Hiermee voorkom je dat zoekmachines de links op de pagina volgen.

• Noarchive: Voorkomt dat er een gecachte versie van de pagina in de zoekresultaten verschijnt.

Voorbeeld: Pagina niet laten indexeren

• Ga naar de pagina “Bedankt voor je aanmelding”.

• Open het SEO tabblad van RankMath.

• Klik op Geavanceerd.

• Zet Noindex aan.

• Sla de pagina op of publiceer.

robots.txt-bestand gebruiken voor deindexeren

De laatste manier om WordPress-pagina’s en -berichten niet te indexeren is door uw robots.txt-bestand te bewerken. Als u echter een WordPress-beginner bent, is deze methode niet aan te raden, omdat u hiervoor sitebestanden moet openen en wijzigen.

Om te beginnen moet u eerst een back-up van uw site maken, voor het geval er tijdens dit proces iets misgaat. Vervolgens moet u uw site verbinden met een File Transfer Protocol (FTP)-client zoals FileZilla.

Zoek vervolgens uw hoofdmapmap, die het label public_html moet hebben:

Toegang tot het robots.txt-bestand in FileZilla om WordPress-pagina’s en -berichten niet te indexeren. In deze map vindt u het robots.txt-bestand. Als u nog geen robots.txt-bestand heeft, kunt u er een maken.

Daarna moet u een regel aan uw robots.txt-bestand toevoegen die zoekmachinebots vertelt de betreffende pagina of post niet te crawlen. Om dit te doen, opent u het robots.txt-bestand met uw editor en voegt u de volgende regels bovenaan toe:

User-agent: * Disallow: /jouw-post-of-pagina-urlHier vertegenwoordigt het sterretje alle potentiële bots. Ondertussen moet je de Disallow-regel aanpassen om de pagina of het bericht op te nemen dat je wilt uitsluiten. Nadat u uw wijzigingen heeft aangebracht, moet u deze opslaan en het bestand vervolgens opnieuw uploaden.

Houd er echter rekening mee dat deze methode niet garandeert dat uw pagina of bericht helemaal niet wordt geïndexeerd; het betekent dat deze niet wordt gecrawld. Het kan dus nog steeds in de zoekresultaten terechtkomen. Dit kan bijvoorbeeld gebeuren als iemand anders ernaar linkt.

Google raadt deze methode zelfs niet aan als er geen specifieke inhoud wordt geïndexeerd. Toch wilt u deze aanpak wellicht gebruiken om te voorkomen dat uw site overspoeld wordt met verzoeken.